Wie alle neuen Technologien, so gibt es auch bei KI viel Raum für Spekulation über mögliche Gefahren und Verheißungen. Nachdem Teil 1 unserer Blogreihe Objektivität von KI und dem Mythos des Jobkillers genauer betrachtet hat, geht es heute um Kontrolle, Überwachung und den gläsernen Menschen sowie Fehler und Optimierungspotential.

Kontrolle, Überwachung, gläserner Mensch

KI ermöglicht es, große Datenmengen zielgereichtet und mit geringem Aufwand auszuwerten. Wenn es sich nun um personenbezogene Daten handelt, bietet das die Gefahr der Manipulation: Die großen Internetkonzerne nutzen dies bereits, um uns mit Werbung zu Produkten zu „versorgen“, die wir wahrscheinlich bald kaufen. Auch wird durch moderne Gesichtserkennung die automatische Verfolgung von Personen auf öffentlichen Plätzen möglich, was jedem Anhänger der Privatsphäre schaudert. Was in China bereits Wirklichkeit ist, wird hierzulande am Berliner Bahnhof Südkreuz als Pilotversuch getestet.

Doch manchmal wird auch das Versprechen zielgenauer Werbung nicht gehalten, nur Relevantes anzuzeigen: So scheinen KI-Algorithmen noch nicht zu verstehen, dass Personen genau dann am aller wenigsten eine Waschmaschine bestellen werden, wenn sie gerade erst eine gekauft haben.

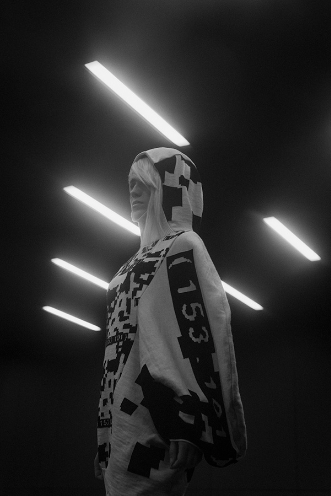

Und auch gegen smarte Überwachung gibt es stilechte Gegenmaßnahmen: Die Leipziger Designerin Nicole Scheller entwirft Mode, die in Zukunft gängige Gesichtserkennungsprogramme verwirren soll. Die Kollektion befindet sich zwar noch im Prototypen-Status, konnte aber bereits einfache Algorithmen aufs Glatteis führen.

Bildnachweis: Fotograf: Franz Grünewald, Model: Christina Dalbert, Design: Nicole Scheller, www.urbnprvcy.com

Fehler oder Optimierungspotential

Der Autopilot von Tesla könnte das Leben von Millionen retten, aber zuerst wird er einige Menschen töten. Wissenschaft und Technik bringen die Menschheit voran, aber ist es moralisch korrekt?

Wer haftet, wenn KI versagt?

Systeme mit künstlicher Intelligenz machen Fehler. Deshalb müssen sie kontrolliert werden. Allerdings arbeitet auch KI-Software nicht fehlerfrei. Wenn der Roboter beim Verpacken eines Koteletts mal danebengreift, ist das nicht so schlimm. Wenn jedoch ein autonom fahrendes Fahrzeug Wände und Boden verwechselt, kann es zu einem schwerwiegenden Unfall führen. Auch ein Algorithmus kann Fehler machen, doch bislang ist die Haftungsfrage unklar. Das europäische Parlament empfiehlt einen Rechtsstatus für KI – die elektronische Person.

KI lernt aus Fehlern

Künstliche Intelligenz verbessert die Erkennungsgenauigkeit durch Training. Dadurch werden weniger Fehlentscheidungen von KI-Systemen getroffen. Der Tesla-Autopilot verwendet Computer Vision, um alle Situationen im Straßenverkehr zu erkennen. Die Systeme müssten in der Lage sein, riesige Datenmengen mit einer Geschwindigkeit zu sammeln, die der menschlichen Fähigkeit zur Tiefen- und Geschwindigkeitserkennung entspräche. In dünn besiedelten Gebieten funktioniert das bereits sehr gut. In dicht besiedelten Gebieten wie San Francisco, mit hohem Verkehrsaufkommen und komplexen Situationen hat solch ein System hingegen definitiv mehr Mühe.

Quellen:

Raimund. S (2021): Teala präsentiert Supercomputer für Vision-Only_Ansatz beim autonomen Fahren, https://t3n.de/news/tesla-supercomputei-autonomes-fahren-radar-1386513/ letzter Zugriff: 30.06.2021.

https://weberbank-diskurs.de/wer-haftet-wenn-kuenstliche-intelligenz-versagt letzter Zugriff: 30.06.2021.